人工智能的风险管理策略

1.标准制定和国际合作

人工智能的风险管理首先涉及到标准的制定和国际合作。由于技术自身固有的脆弱性和监管体系落后于技术发展,各国对人工智能风险治理尚未形成统一认识,出现了新问题快速涌现,治理规则缺失的困境。因此,加强人工智能风险治理,必须重视标准的制定。一项与技术标准有效结合的关键技术一旦占领某行业或领域,就很容易掌握市场主动权。此外,加强人工智能风险治理,也需要加强人工智能国际合作。当前国际竞争形势复杂多变,必须放眼世界和未来。

2.风险教育和隐私保护

人工智能的风险管理还包括风险教育和隐私保护。员工意识是人工智能风险管理的一个重要组成部分。首先,让所有参与者,包括CISO、首席隐私官、首席数据官以及法律和合规官,重新调整他们对AI的心态。他们应该明白,人工智能“不像任何其他应用程序”——它会带来独特的风险,需要特定的控制来减轻此类风险。然后,与业务利益相关者联系,以扩大对需要管理的AI风险的认识。

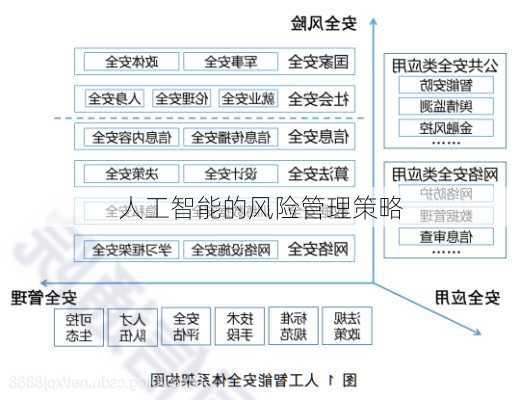

3.风险管理框架

人工智能的风险管理还需要建立风险管理框架。美国国家标准与技术研究院(NIST)近期发布的人工智能风险管理框架对“风险”进行了定义,提出“风险”是指***发生概率和相应***后果的综合度量。NIST提出的框架概念文件以有意义、可操作和可测试的方式提出了人工智能系统可信度的衡量标准,并列出有效的人工智能风险管理***的组成部分。

4.多方利益相关者的参与

人工智能的风险管理需要多方利益相关者的参与。AI生态系统是众多不同利益相关者的家园,包括开发人员,用户,部署者和评估人员。对于组织而言,跨业务和社会关系大规模识别、评估、优先排序、响应和沟通风险可能是一项艰巨的任务。这些挑战将人工智能风险的异质性放大,无论是在程度上还是在性质上,其中可能包括有害偏见,对安全的威胁,隐私和消费者保护等。自愿共识驱动形成的框架可以帮助创建和维护人工智能驱动系统和商业模式核心的信任,并进行灵活性创新,使得该框架随着技术的发展而发展。

总的来说,人工智能的风险管理是一个复杂的过程,需要多方面的努力和配合。通过标准制定、国际合作、风险教育和隐私保护以及建立风险管理框架,我们可以更好地管理和控制人工智能的风险,实现人工智能的安全和可持续发展。

追问

延伸阅读